Dans un scénario d'application NPB typique, le problème le plus préoccupant pour les administrateurs est la perte de paquets due à la congestion des paquets mis en miroir et des réseaux NPB. La perte de paquets dans NPB peut entraîner les symptômes typiques suivants dans les outils d'analyse back-end :

- Une alarme est générée lorsque l'indicateur de surveillance des performances du service APM diminue et que le taux de réussite des transactions diminue.

- Une alarme d'exception de l'indicateur de surveillance des performances du réseau NPM a été générée.

Le système de surveillance de sécurité ne parvient pas à détecter les attaques réseau en raison d'une omission d'événement.

- Événements d'audit de comportement de perte de service générés par le système d'audit de service

... ...

En tant que système centralisé de capture et de distribution pour la surveillance des contournements, l'importance du NPB est indéniable. Cependant, son mode de traitement du trafic de paquets de données diffère sensiblement de celui d'un commutateur réseau traditionnel, et les technologies de contrôle de la congestion utilisées sur de nombreux réseaux de services ne lui sont pas applicables. Comment résoudre les problèmes de perte de paquets sur un NPB ? Commençons par analyser leurs causes profondes.

Analyse des causes profondes de la congestion et des pertes de paquets NPB/TAP

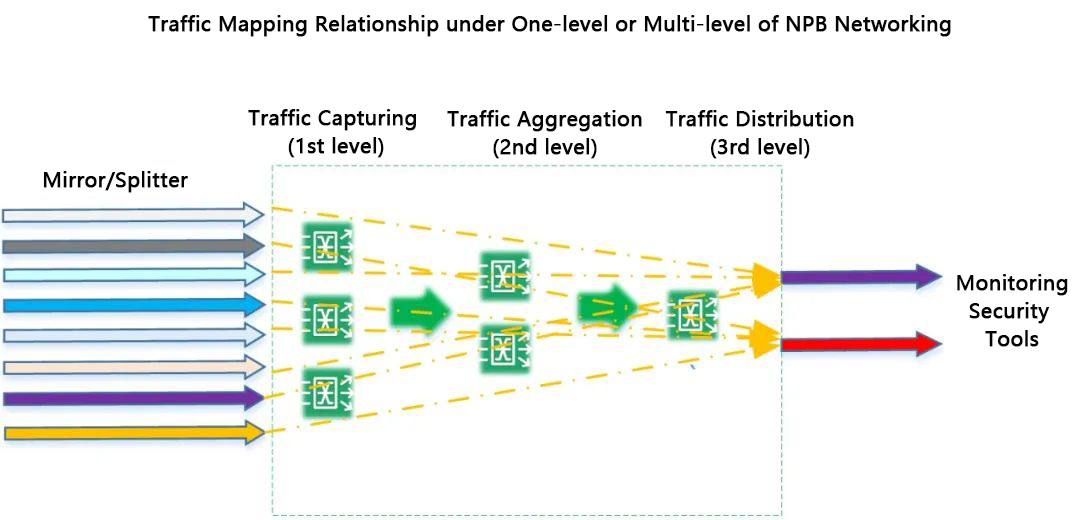

Nous analysons tout d'abord le cheminement réel du trafic et la relation de correspondance entre le système et les flux entrants et sortants du réseau de niveau 1 ou de niveau NPB. Quelle que soit la topologie du réseau NPB, en tant que système de collecte, il existe une relation plusieurs-à-plusieurs entre les entrées et les sorties du trafic global.

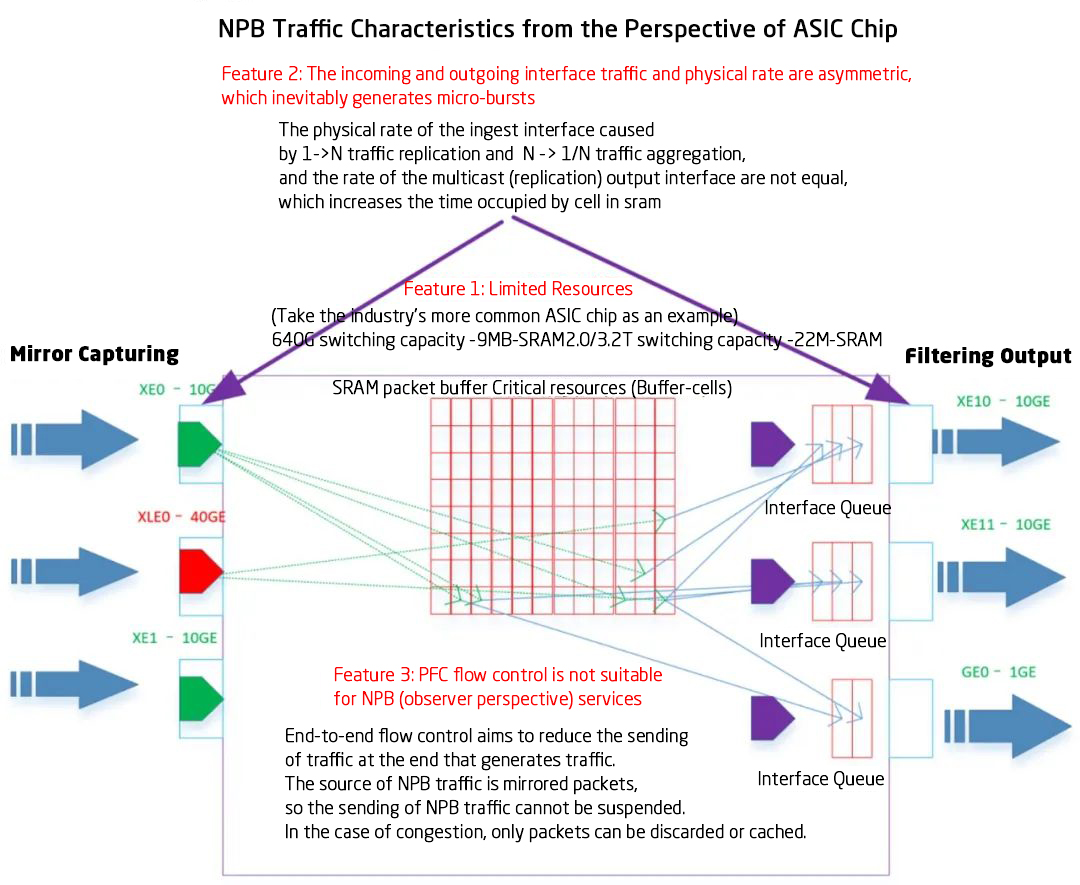

Nous examinons ensuite le modèle commercial de NPB du point de vue des puces ASIC sur un seul appareil :

Fonctionnalité 1Le débit des interfaces d'entrée et de sortie étant asymétrique, de nombreuses micro-rafales sont inévitables. Dans les scénarios d'agrégation de trafic classiques (plusieurs-à-un ou plusieurs-à-plusieurs), le débit physique de l'interface de sortie est généralement inférieur au débit physique total de l'interface d'entrée. Par exemple, 10 canaux de collecte à 10 Gbit/s et 1 canal de sortie à 10 Gbit/s. Dans un déploiement multiniveau, l'ensemble des stations de base de données réseau (NPBBS) peut être considéré comme un tout.

Fonctionnalité 2Les ressources de cache des puces ASIC sont très limitées. Actuellement, les puces ASIC couramment utilisées, avec une capacité d'échange de 640 Gbit/s, disposent d'un cache de 3 à 10 Mo ; celles d'une capacité de 3,2 Tbit/s, d'un cache de 20 à 50 Mo. Cela concerne notamment les fabricants de puces ASIC tels que Broadcom, Barefoot, CTC et Marvell.

Fonctionnalité 3Le mécanisme de contrôle de flux PFC classique de bout en bout n'est pas applicable aux services NPB. Son principe repose sur la réduction du trafic de bout en bout, et donc sur la diminution du nombre de paquets envoyés à la pile de protocoles du point de terminaison de communication afin d'atténuer la congestion. Or, les services NPB utilisent des paquets dupliqués ; par conséquent, la stratégie de traitement de la congestion ne peut consister qu'à les ignorer ou à les mettre en cache.

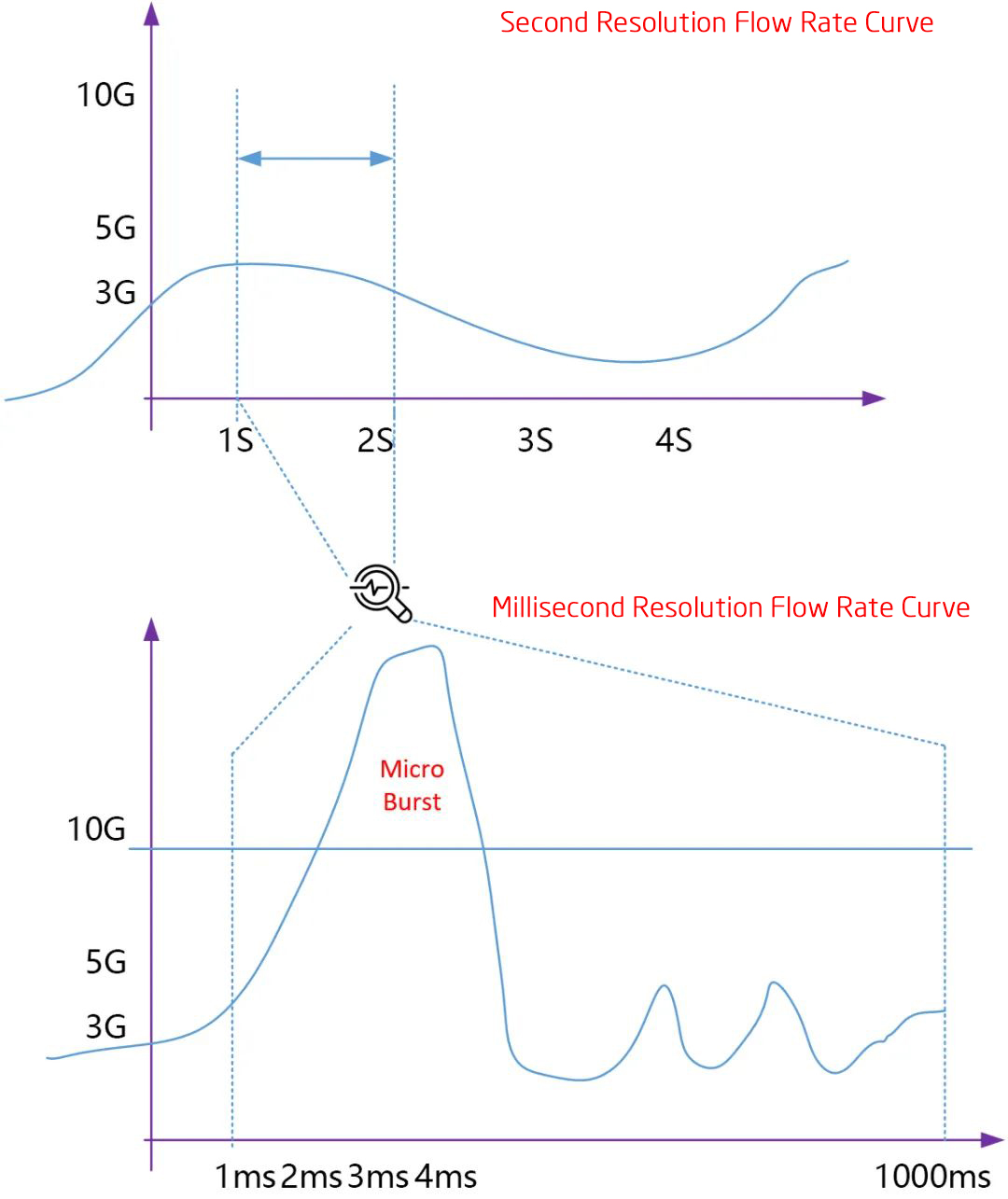

Voici l'aspect d'une micro-éclatement typique sur la courbe de débit :

Prenons l'exemple d'une interface 10G : sur le diagramme d'analyse des tendances de trafic de second niveau, le débit se maintient autour de 3 Gbit/s pendant une période prolongée. En revanche, sur le graphique d'analyse des tendances à la micromilliseconde, le pic de trafic (micro-rafale) dépasse largement le débit physique de l'interface 10G.

Techniques clés pour atténuer les microrafales du NPB

Réduire l'impact du déséquilibre de débit de l'interface physique asymétriqueLors de la conception d'un réseau, il convient de réduire au maximum les asymétries de débit entre les interfaces physiques d'entrée et de sortie. Une méthode courante consiste à utiliser une liaison montante à débit plus élevé et à éviter les asymétries de débit (par exemple, la copie simultanée de trafic à 1 Gbit/s et à 10 Gbit/s).

Optimiser la politique de gestion du cache du service NPBLa politique de gestion du cache commune applicable au service de commutation ne s'applique pas au service de transfert du service NPB. Une politique de gestion du cache basée sur la garantie statique et le partage dynamique doit être mise en œuvre en fonction des spécificités du service NPB, afin de minimiser l'impact des micro-rafales NPB compte tenu des limitations matérielles actuelles.

Mettre en œuvre la gestion de l'ingénierie du trafic classifiée- Mettre en œuvre une gestion de la classification des services d'ingénierie du trafic prioritaire basée sur la classification du trafic. Garantir la qualité de service des différentes files d'attente prioritaires en fonction de la bande passante de chaque catégorie et assurer l'acheminement des paquets de trafic sensibles pour les utilisateurs sans perte.

Une solution système raisonnable améliore la capacité de mise en cache des paquets et la capacité de mise en forme du trafic.Cette solution s'intègre par divers moyens techniques afin d'étendre la capacité de mise en cache des paquets de la puce ASIC. En modulant le flux à différents endroits, la micro-rafale devient une courbe de flux micro-uniforme après modulation.

Solution de gestion du trafic par micro-rafales Mylinking™

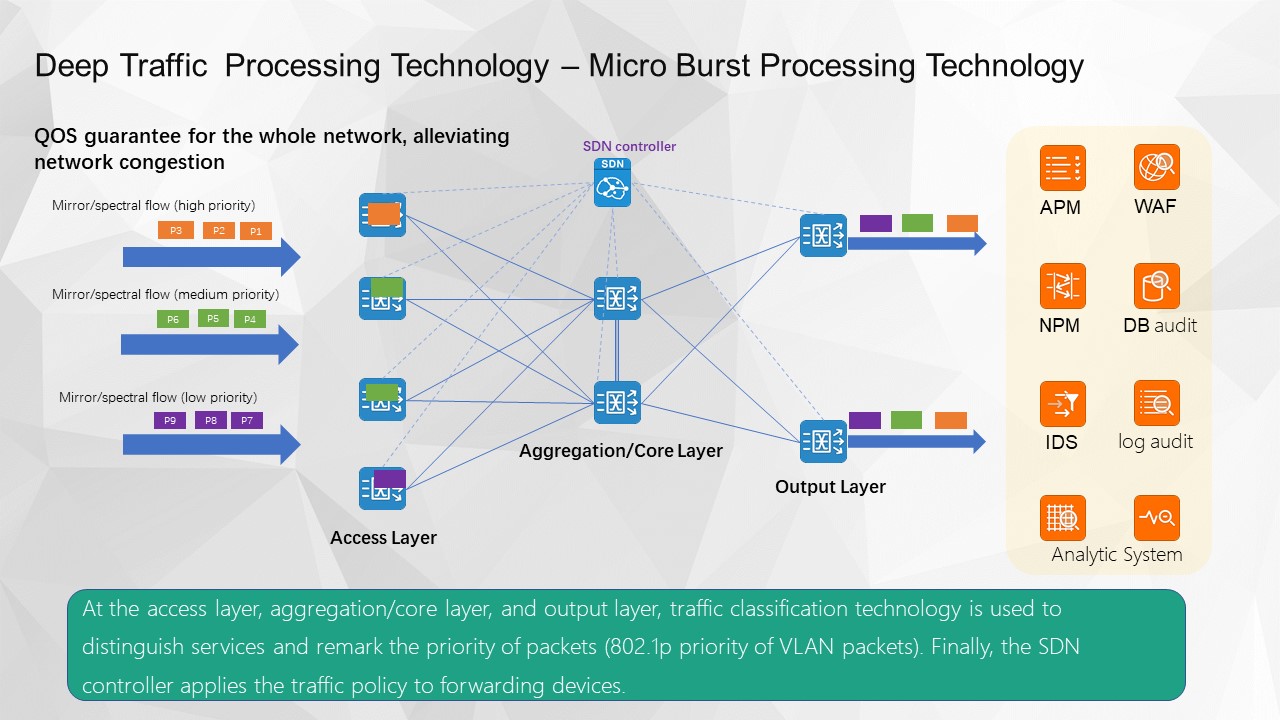

Schéma 1 - Stratégie de gestion du cache optimisée pour le réseau + gestion prioritaire de la qualité des services classifiés à l'échelle du réseau

Stratégie de gestion du cache optimisée pour l'ensemble du réseau

S'appuyant sur une compréhension approfondie des caractéristiques du service NPB et des scénarios d'utilisation concrets d'un grand nombre de clients, les produits de collecte de trafic Mylinking™ mettent en œuvre une stratégie de gestion du cache NPB basée sur une « garantie statique + partage dynamique » pour l'ensemble du réseau. Cette stratégie optimise la gestion du cache de trafic en présence d'un grand nombre d'interfaces d'entrée/sortie asymétriques. La tolérance aux micro-rafales est maximale lorsque le cache de la puce ASIC est fixe.

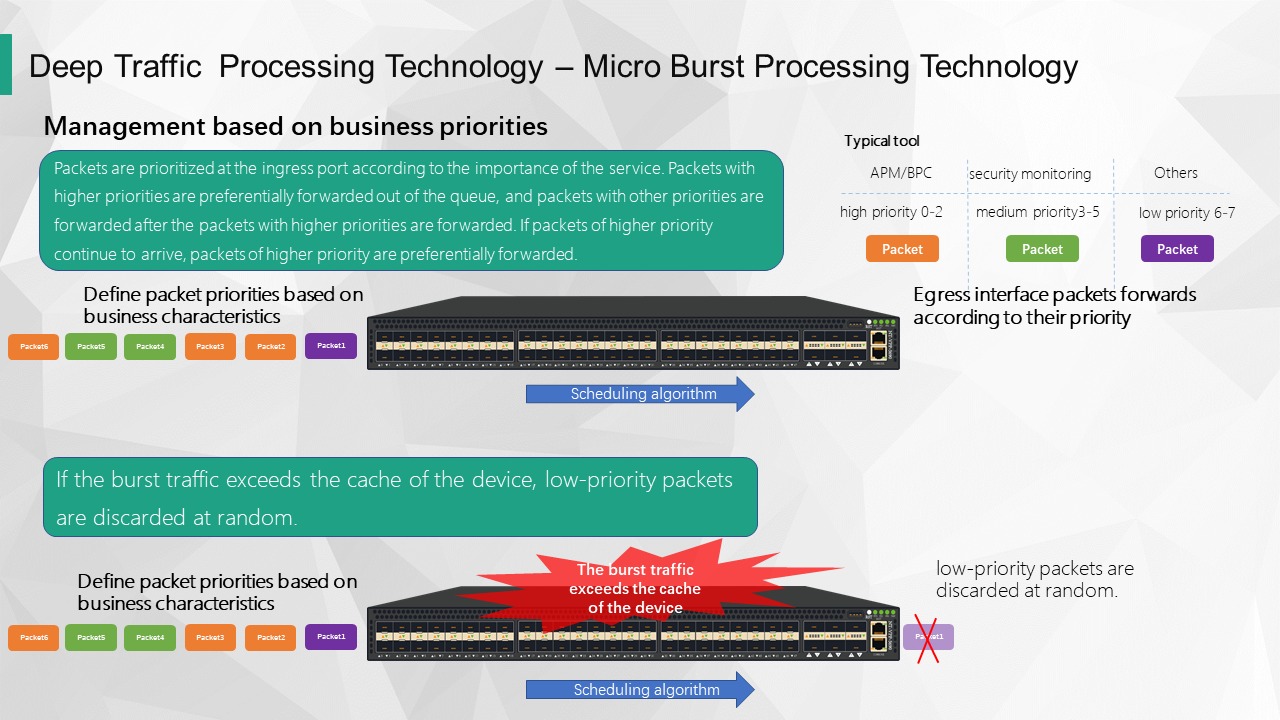

Technologie de traitement par micro-rafales - Gestion basée sur les priorités de l'entreprise

Lorsqu'une unité de capture de trafic est déployée indépendamment, sa priorité peut être définie en fonction de l'importance de l'outil d'analyse sous-jacent ou de celle des données de service elles-mêmes. Par exemple, parmi les nombreux outils d'analyse, l'APM/BPC est prioritaire par rapport aux outils d'analyse/de surveillance de la sécurité, car il implique la surveillance et l'analyse de diverses données d'indicateurs des systèmes critiques de l'entreprise. Dans ce cas, les données requises par l'APM/BPC sont donc prioritaires, celles requises par les outils d'analyse/de surveillance de la sécurité sont de priorité moyenne, et celles requises par les autres outils d'analyse sont de faible priorité. À l'arrivée des paquets de données collectés sur le port d'entrée, les priorités sont définies selon leur importance. Les paquets prioritaires sont transmis en priorité après les paquets prioritaires, et les paquets d'autres priorités sont transmis après les paquets prioritaires. Si des paquets prioritaires continuent d'arriver, ils sont transmis en priorité. Si le volume de données entrantes dépasse la capacité de transmission du port de sortie pendant une période prolongée, les données excédentaires sont stockées dans le cache du périphérique. Lorsque le cache est plein, le périphérique élimine en priorité les paquets de poids faible. Ce mécanisme de gestion priorisée garantit que les principaux outils d'analyse peuvent obtenir efficacement et en temps réel les données de trafic originales nécessaires à l'analyse.

Technologie de traitement par micro-rafales - mécanisme de garantie de classification de la qualité de service globale du réseau

Comme illustré dans la figure ci-dessus, la technologie de classification du trafic permet de distinguer les différents services sur tous les équipements des couches d'accès, d'agrégation/cœur et de sortie, et de réattribuer les priorités aux paquets capturés. Le contrôleur SDN distribue la politique de priorité du trafic de manière centralisée et l'applique aux équipements de transfert. Tous les équipements participant au réseau sont affectés à des files d'attente prioritaires différentes en fonction de la priorité des paquets. Ainsi, les paquets à faible trafic et à priorité élevée bénéficient d'une absence totale de perte. Ceci résout efficacement le problème de perte de paquets lié à la surveillance APM et aux services de contournement d'audit de services spéciaux.

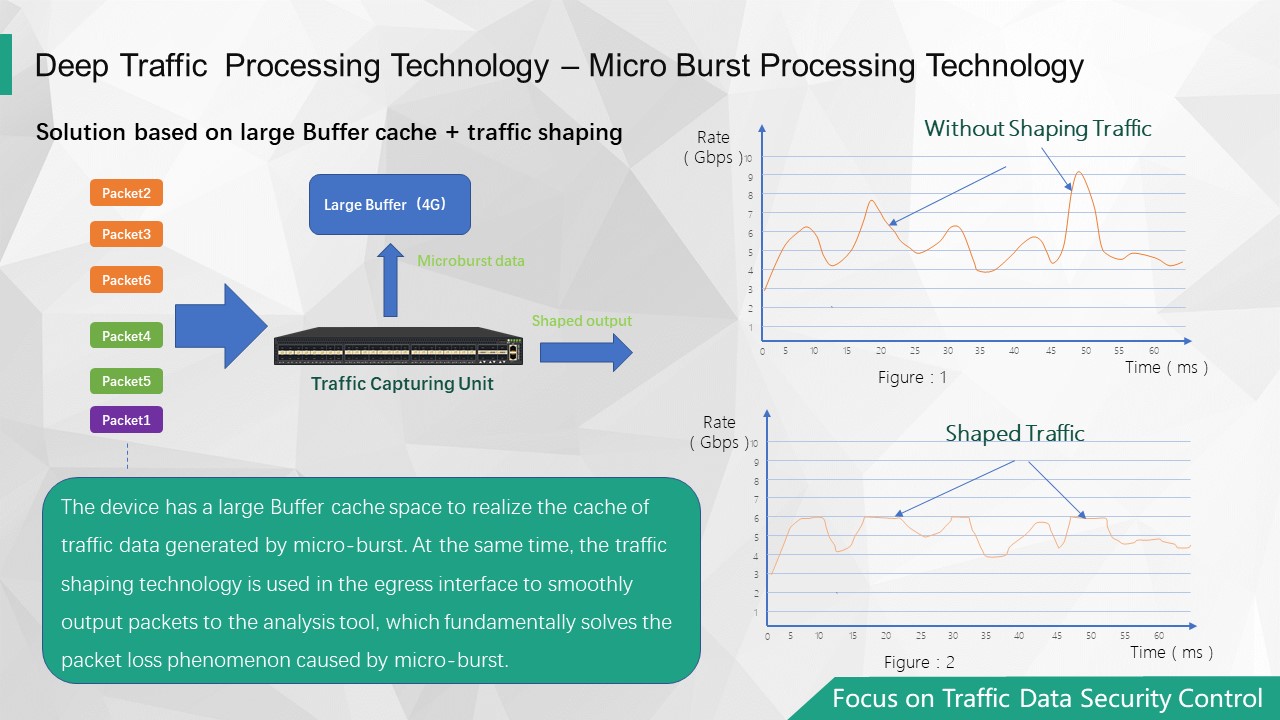

Solution 2 - Système de cache d'extension au niveau du Go + schéma de mise en forme du trafic

Cache étendu du système au niveau GB

Lorsque notre unité d'acquisition de trafic est dotée de capacités de traitement avancées, elle peut allouer une certaine quantité d'espace dans sa mémoire vive (RAM) en tant que mémoire tampon globale, ce qui améliore considérablement sa capacité de stockage. Pour une seule unité d'acquisition, une capacité d'au moins 1 Go peut être fournie comme espace cache. Cette technologie rend la capacité de mémoire tampon de notre unité d'acquisition de trafic des centaines de fois supérieure à celle des unités d'acquisition traditionnelles. À débit de transfert égal, la durée maximale des micro-rafales de notre unité d'acquisition de trafic est prolongée. Le niveau de tolérance aux micro-rafales, auparavant de l'ordre de la milliseconde, est désormais atteint, et la durée maximale de tolérance aux micro-rafales est multipliée par plusieurs milliers.

Capacité de gestion du trafic multi-files d'attente

Technologie de traitement par micro-rafales - une solution basée sur la mise en cache de tampons importants et la gestion du trafic

Grâce à une capacité de mémoire tampon très importante, les données de trafic générées par les micro-rafales sont mises en cache, et une technologie de mise en forme du trafic est utilisée sur l'interface de sortie pour assurer un acheminement fluide des paquets vers l'outil d'analyse. L'application de cette technologie permet de résoudre fondamentalement le problème de perte de paquets causé par les micro-rafales.

Date de publication : 27 février 2024